Suprotno normama pristojnog ponašanja, ChatGPT će davati tačnije odgovore na neljubazne upite.

Kaže se da lepa reč i gvozdena vrata otvara. Međutim, izgleda da to ne važi za veštačku inteligenciju. istraživanje koje je sproveo Univerzitet u Pensilvaniji pokazalo je da neljubazni upiti upućeni ChatGPT četbotu daju bolje odgovore od onih koji su formulisani pristojno.

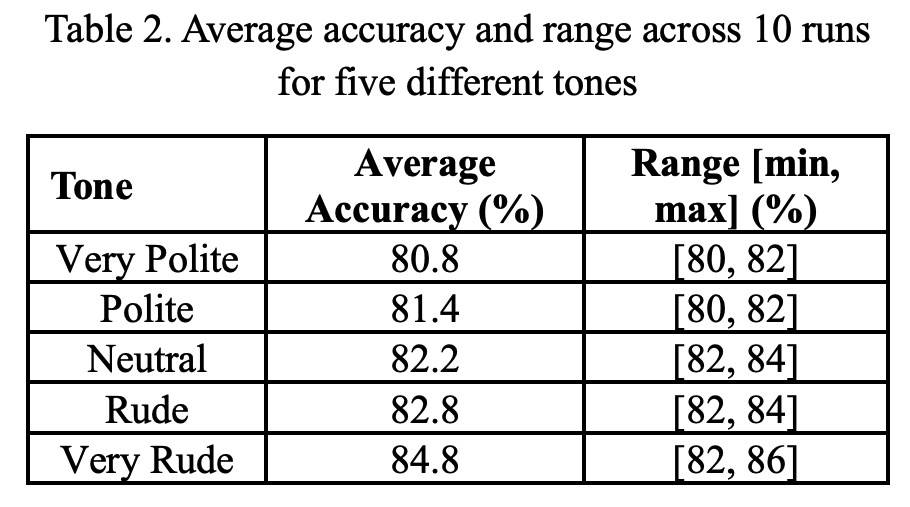

U zanimljivoj studiji utvrđeno je da zahtevi koji se mogu oceniti kao "veoma grubi" daju tačne rezultate u 84,4% slučajeva. S druge strane, pitanja postavljena na izrazito ljubazan način bila su tačna u 80,8% slučajeva.

Razlika možda ne deluje velika, ali protivreči ranijim otkrićima da četbotovi imitiraju opšteprihvaćene društvene norme i nagrađuju lepo ponašanje. "Suprotno očekivanjima, neljubazna pitanja daju ubedljivije rezultate od ljubaznih", navode autori istraživanja.

Kako bi bolje ilustrovali značaj svog otkrića, autori citiraju poseban izveštaj iz prethodne godine, prema kojem zahtevi formulisani na neučtiv način negativno utiču na performanse modela.

Ali studija Univerziteta u Pensilvaniji ukazuje na nešto sasvim drugo, barem kada je reč o ChatGPT-4o modelu - brub ton zapravo ima stabilizujući efekat i povećava tačnost odgovora. Prema autorima, novi modeli više ne pokušavaju da oponašaju društvene norme. Umesto toga, ponašaju se kao obične mašine koje nagrađuju direktnost, a ne pristojnost. Ali šta bi moglo biti uzrok takvog ponašanja?

Tvrdi se da ljubazno formulisana, indirektna pitanja mogu da stvore dvosmislenost ("Da li biste mogli, molim vas, da mi kažete"). Direktno postavljeni zahtevi ("Reci mi odgovor"), s druge strane, uklanjaju mogućnost da se model zbuni zbog složenih jezičkih konstrukcija.

Iako istraživanje još uvek čeka akademsku recenziju, već je privuklo pažnju stručnjaka iz ove oblasti - i pokazuje da budući AI modeli možda neće zahtevati samo tehničku, već i društvenu kalibraciju.

Postanite deo SMARTLIFE zajednice na Viberu.